Camera-Augmented C-Arm

Das Projekt CAMC steht für Camera Augmented Mobile C-Arm und beinhaltet die Entwicklung von Augmented-Reality-Visualisierungen für Image-Guided Surgery.

Im Projekt CAMC werden konventionelle intraoperative Röntgensysteme durch Kamera- und Trackingsysteme erweitert, um intuitive und multimodale Augmented Reality Visualisierungen zu ermöglichen.

Mobile C-Arm Systeme sind unverzichtbare Werkzeuge im Alltag der traumatologischen und orthopädischen Chirurgie, da viele Eingriffe unter Fluoroskopiekontrolle durchgeführt werden. Das es nicht bei allen orthopädischen Eingriffen möglich ist, den Eingriff präoperativ zu planen, wird Röntgen-Bildgebung in der Operation eingesetzt, um sich zu orientieren, Entscheidungen zu treffen und Schritte zu verifizieren. Obwohl sich diese Form der Bildgebung als sehr nützlich erwiesen hat, kann es besonders für unerfahrene Chirurgen sehr anspruchsvoll sein, die 3D räumliche Lage nur anhand 2D Röntgenaufnahmen zu bestimmen.

Im Forschungsgebiet der medizinischen Bildgebung wurden erhebliche Anstrengungen unternommen, um die 2D Bildgebung durch eine interaktive Darstellung von 3D Rekonstruktionsvolumina zu ersetzen. Neben präoperativen Verfahren, wie Computed Tomography (CT) und Magnetresonanztomographie (MRT), wurden auch intraoperative Verfahren, wie Cone-Beam-Computed-Tomography, CBCT, eingesetzt. Im Rahmen unseres Projekts werden nun konventionelle, intraoperative C-Arm Systeme mit einer fest am Rahmes des Gerätes befestigter (Tracking-)Kamera erweitert. Durch einen Kalibrierungsvorgang arbeiten die beiden Modalitäten zusammen, sodass die optischen und radiologischen Daten fusioniert werden können. Das resultierende System ermöglicht intuitive AR Visualisierungen. Seit der Veröffentlichung des ersten Konzepts im Jahre 1999 [1] wurden zahlreiche Weiterentwicklungen vorgeschlagen, wie beispielsweise die Kalibrierung von 2D/3D Kameras [2-4], Trackern [5] und seit Neuestem HMD-Systemen [6].

Weitere Informationen zum Forschungsprojekt, alle Publikationen und einen historischen Überblick über das Projekt sowie eine Präsentation ausgewählter Arbeiten finden Sie auf der Homepage von Medical Augmented Reality.

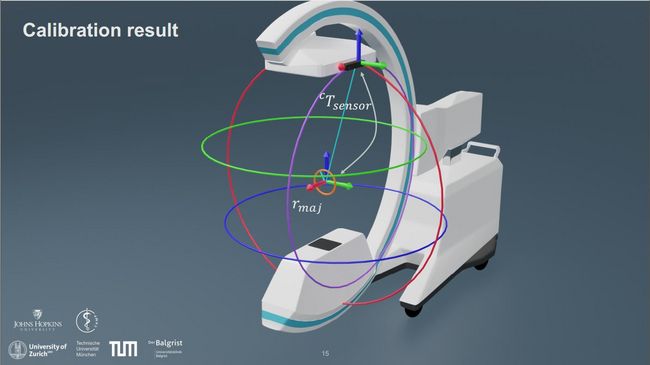

In unserem aktuellen Forschungsprojekt wurde ein neuartiger Algorithmus zur Kalibrierung von unbeweglich am Detektorgehäuse befestigten Sensoren entwickelt. [7] Durch Nutzung eines Tracking-Systems kann dabei allein durch die Analyse der mechanischen Konfiguration des Röntgensystems das Rotationszentrum des C-arms bestimmt werden. Dabei werden, wie im Video ersichtlich, Trajektorien während der Rotation des mobilen C-arm Systems um dessen Hauptachsen unabhängig voneinander aufgezeichnet. Diese Trajektorien umspannen die Oberfläche eines Spindeltorus, dessen mathematische Formulierung das Rotationszentrum des Systems beschreibt.

Durch die Dekomposition dieses 3D-Fitting-Problems in zweidimensionale Subprobleme können die aufgezeichneten Trajektorien verwendet werden, um die Position und Orientierung des Rotationszentrums zu bestimmen, welches für die räumliche Lokalisierung von Röntgenbildern und der Rekonstruktion von 3D Volumina der Patientenanatomie von entscheidender Bedeutung ist. Das Ergebnis dieser Offline-Kalibrierung soll für intuitive AR Anwendungen in der orthopädischen Chirurgie eingesetzt werden.

Referenzen

1. Navab, N., Bani-Kashemi, A., and Mitschke, M., “Merging visible and invisible: Two camera-augmentedmobile c-arm (camc) applications,”IWAR’99, 134–141, IEEE (1999).

2. Habert, S., Gardiazabal, J., Fallavollita, P., and Navab, N., “Rgbdx: first design and experimental validationof a mirror-based rgbd x-ray imaging system,”ISMAR’15, 13–18, IEEE (2015).

3. Albiol, F., Corbi, A., and Albiol, A., “Geometrical calibration of x-ray imaging with rgb cameras for 3dreconstruction,”IEEE Transactions on Medical Imaging35(8), 1952–1961 (2016).

4. Lee, S. C., Fuerst, B., Fotouhi, J., Fischer, M., Osgood, G., and Navab, N., “Calibration of rgbd camera andcone-beam ct for 3d intra-operative mixed reality visualization,”IJCAR’1611(6), 967–975 (2016).

5. Reaungamornrat, S., Otake, Y., Uneri, A., Schafer, S., Mirota, D., Nithiananthan, S., Stayman, J., Kleinszig,G., Khanna, A., Taylor, R., and Siewerdsen, J., “An on-board surgical tracking and video augmentationsystem for c-arm image guidance,”IJCAR’127(4), 647–665 (2012).

6. Fotouhi, J., Unberath, M., Song, T., Gu, W., Johnson, A., Osgood, G., Armand, M., and Navab, N.,“Interactive flying frustums (iffs): spatially aware surgical data visualization,”IJCAR’1914(6) (2019)

7. Lee, S.C., Seibold, M., Fürnstahl, P., Farshad, M., Navab, N., “Pivot calibration concept for sensor attached mobile c-arms” Proceedings Volume 11315, Medical Imaging 2020: Image-Guided Procedures, Robotic Interventions, and Modeling; 1131503 (2020)